KI-Halluzinationen in der juristischen Praxis: Ursachen und technische Lösungsansätze von PyleHound

Der Einsatz von Künstlicher Intelligenz im juristischen Arbeitsalltag bringt enorme Effizienzvorteile, wirft jedoch auch eine zentrale Frage auf: Wie verlässlich sind die Ergebnisse? Ein aktuelles Beispiel hierfür liefert ein Vorfall, bei dem KI-Fehlzitate vor dem Landgericht Frankfurt eingereicht wurden. Doch was genau steckt hinter diesen Fehlern, warum passieren sie, und wie stellt PyleHound technisch sicher, dass Sie sich auf die Suchergebnisse verlassen können?

Was sind KI-Halluzinationen genau?

Unter dem Begriff „Halluzination“ versteht man im Bereich der Künstlichen Intelligenz das Phänomen, dass ein Modell überzeugend klingende, aber faktisch falsche oder frei erfundene Informationen ausgibt. Im juristischen Kontext bedeutet dies konkret: Die KI zitiert beispielsweise ein BGH-Urteil, das nie gesprochen wurde, verweist auf eine Vertragsklausel, die im hochgeladenen Dokument gar nicht existiert, oder erfindet abweichende Fristen. Das Tückische daran ist, dass diese Falschinformationen sprachlich fehlerfrei und im Kontext absolut plausibel präsentiert werden, sodass sie auf den ersten Blick wie legitime juristische Fakten wirken.

Warum halluzinieren KI-Sprachmodelle überhaupt?

KI-Modell wie ChatGPT, Anthropics Claude oder Googles Gemini fallen in die Kategorie der "großen Sprachmodelle" (Large Language Models, LLMs). Diese Modelle sind keine Wissensdatenbanken im klassischen Sinne, in denen feststehende Fakten abgerufen werden. Vielmehr handelt es sich um hochentwickelte, probabilistische Systeme zur Textgenerierung. Auf eine Eingabe hin berechnet das Modell schlichtweg, welches Wort statistisch gesehen als Nächstes am wahrscheinlichsten folgen sollte.

Fehlt dem Modell der konkrete faktische Kontext zu einem Sachverhalt, priorisiert es die Generierung eines flüssigen, sprachlich plausiblen Textes. In der juristischen Praxis führt dieser Mechanismus dazu, dass die KI Aktenzeichen, Paragraphen oder Begründungen formuliert, die absolut logisch und überzeugend klingen, in der Realität jedoch nicht existieren. Die KI generiert keine bewussten Falschaussagen, sondern liefert lediglich die wahrscheinlichste sprachliche Fortsetzung.

Der Schlüssel zur Lösung liegt im Kontext: Das Risiko von Halluzinationen lässt sich drastisch reduzieren, wenn das Modell nicht auf sein abstraktes "Weltwissen" zurückgreifen muss. Wird der KI das benötigte, verifizierte Faktenwissen direkt innerhalb der Konversation zur Verfügung gestellt, sinkt die Notwendigkeit des statistischen Ratens gegen null. Das Modell stützt sich dann auf die real vorliegenden Informationen, anstatt Lücken mit plausiblen Fiktionen zu füllen. Genau dieses Prinzip macht sich PyleHound zunutze.

Wie verhindert PyleHound Halluzinationen?

Um dieses probabilistische Raten zu unterbinden, setzt PyleHound auf eine Architektur, die sich grundlegend von den normalen KI-Chat-Anwendungen unterscheidet. Strenge technische Guardrails sorgen für höchste Präzision und Nachvollziehbarkeit bei der Recherche.

Context Engineering

Unsere Deep-Research-Funktion analysiert jede Zeile der hochgeladenen Dokumente innerhalb eines Projekts und identifiziert semantische Treffer für Ihre Anfrage. Diese Suchtreffer werden zunächst ausschließlich Ihnen als Nutzer präsentiert, bevor das Sprachmodell den Inhalt verarbeitet. Sie entscheiden proaktiv, welche relevanten Textstellen in den Kontext der KI geladen werden. Dieses Prinzip der gezielten Vorauswahl greift ebenso bei unserer juristischen Datenbankanbindung.

Strikte Zitat-Validierung

PyleHound instruiert das LLM im Hintergrund, verwendete Dateien und Zitate exakt zu kennzeichnen. Anschließend validiert das System die Dateinamen und Originalzitate mit den Quelldokumenten. Zitate, die sich nicht verifizieren lassen, werden transparent als solche markiert.

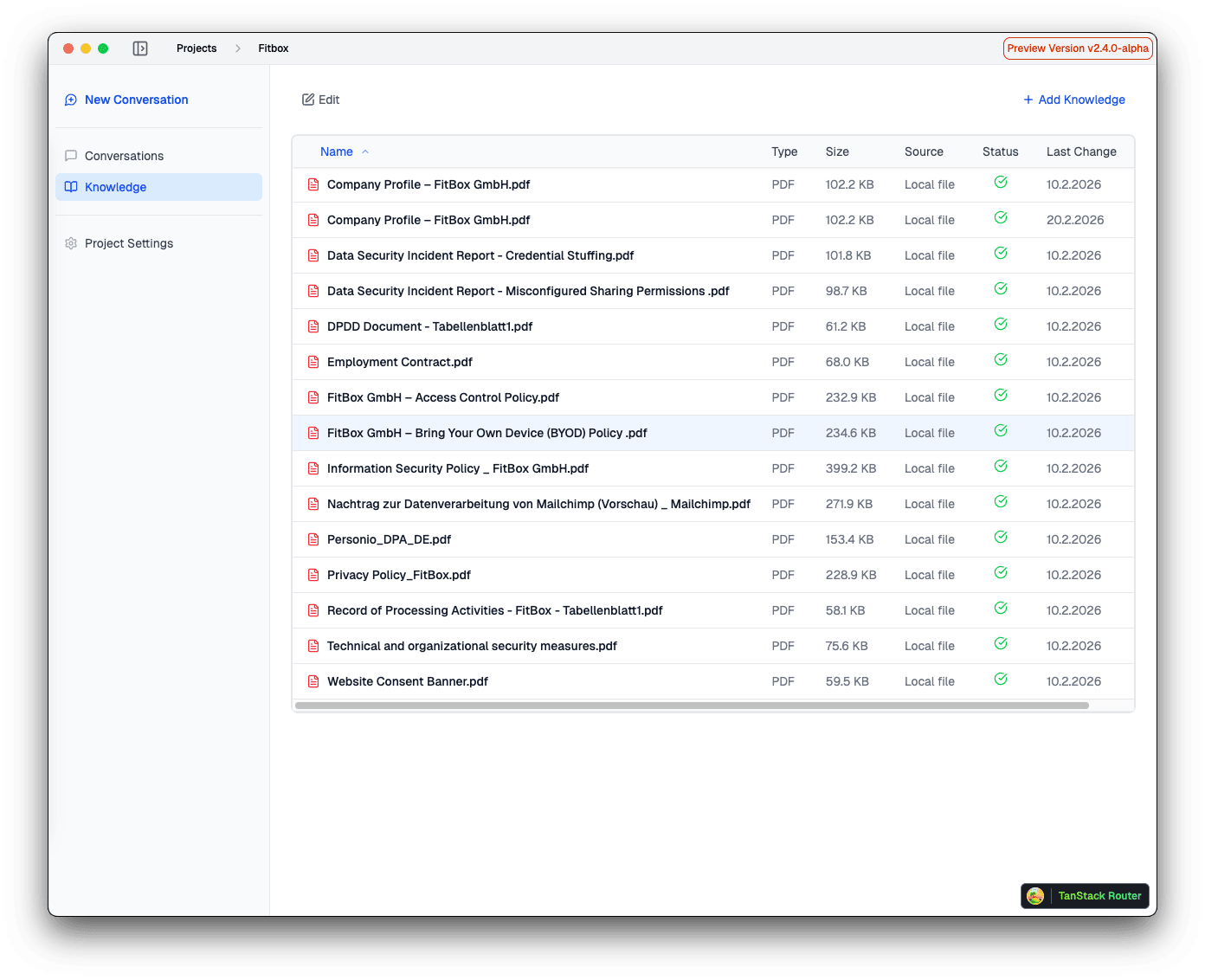

Isolierte Projekträume

PyleHound greift bei der Beantwortung von Suchanfragen immer nur auf die Dokumente zu, die sich im aktuell ausgewählten Projekt befinden. Ein unbeabsichtigtes Vermischen von Daten ist technisch ausgeschlossen. Zusammenhängende Aktenbestände sollten daher stets innerhalb eines gemeinsamen Projekts organisiert werden.

Was müssen Sie als Anwender weiterhin selbst prüfen?

PyleHound nimmt Ihnen die zeitintensive Dokumentenanalyse ab, strukturiert große Datenmengen und bereitet Informationen zielgerichtet und mit exakten Quellenangaben vor. Die abschließende juristische Bewertung und Qualitätskontrolle bleibt jedoch eine rein menschliche Aufgabe.

Als Anwender sichten Sie die von PyleHound transparent ausgewiesenen Quellenlinks, prüfen den originalen Kontext im Dokument und ordnen die Informationen rechtlich ein. Diese anwaltliche Sorgfaltspflicht ist unerlässlich – besonders wenn es um die Frage geht, wer am Ende bei KI-Fehlern haftet. PyleHound liefert Ihnen die verifizierten Fakten in Sekundenschnelle, doch die strategische und rechtliche Führung liegt stets bei Ihnen.